Томского политехнического университета

Newspaper of National Research

Tomsk Polytechnic University

Всемирная сеть большой науки

Стажеры Томского политеха рассказали о первых результатах стажировки в ЦЕРНе

МОЛОДЫЕ УЧЕНЫЕ ТОМСКОГО ПОЛИТЕХНИЧЕСКОГО УНИВЕРСИТЕТА РАССКАЗАЛИ О ПЕРВЫХ РЕЗУЛЬТАТАХ СТАЖИРОВКИ В ЕВРОПЕЙСКОМ ЦЕНТРЕ ЯДЕРНЫХ ИССЛЕДОВАНИЙ (ЦЕРН). СТАЖЕРЫ ТПУ УЧАСТВУЮТ В IT-ДЕПАРТАМЕНТЕ ПРОЕКТА ATLAS НА БОЛЬШОМ АДРОННОМ КОЛЛАЙДЕРЕ. ПЕРВЫЕ ЧЕТЫРЕ МЕСЯЦА СТАЖИРОВКИ УЖЕ ПОЗАДИ, И ПОЛИТЕХНИКАМ ЕСТЬ ЧТО РАССКАЗАТЬ О РЕЗУЛЬТАТАХ СВОЕЙ РАБОТЫ.

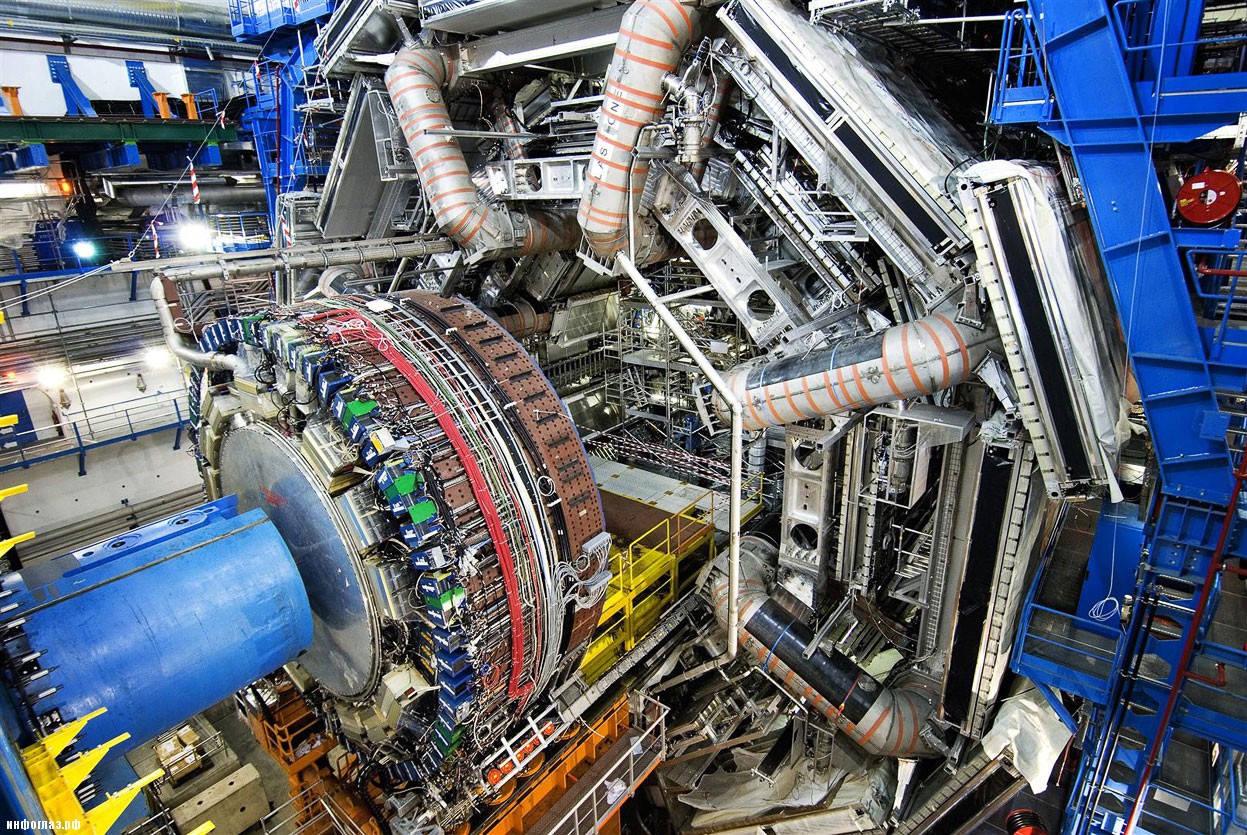

«Обработка данных в ЦЕРНе — главное и основное, чем ученым приходится заниматься», — рассказывают политехники. Большой адронный коллайдер (БАК) — самый большой в мире ускоритель элементарных частиц — оснащен шестью детекторами для шести основных экспериментов ЦЕРНа. Это очень крупные установки с многочисленными датчиками. Например, детектор ATLAS, следящий за протон-протонными столкновениями, величиной с 8-этажный дом.

— Эксперименты на БАК длятся по несколько месяцев. Все это время детекторы фиксируют столкновения частиц, которые происходят непрерывно. Представляете, сколько это информации? Петабайты в секунду! Однако большая ее часть физикам и не нужна. Важны не все столкновения подряд (существенная их часть науке известна), а лишь необычные, подтверждающие ту или иную гипотезу. Это примерно 1 % получаемых данных. Прочие отсеивают специальные программы — триггеры. Даже не буду вдаваться в сложность всего процесса. Скажу только, что физиками была проделана колоссальная работа, чтобы рассчитать предполагаемые результаты столкновений пучков и загрузить их в систему, — рассказывает стажер ЦЕРНа Максим Губин.

Однако, как поясняет политехник, даже этот процент очень велик. Проводятся все новые эксперименты, в систему поступают все новые данные. Чтобы обработать всю собранную на сегодняшний день информацию, по примерным подсчетам, ученым потребуется около 100 лет непрерывных вычислений на нынешних мощностях. Поэтому очень важно придумать, как оптимизировать все необходимые подсчеты.

— Собственно это и является частью нашей работы. В рамках участия в эксперименте ATLAS мы работаем над анализом и хранением данных большого объема (Big Data), — заключает молодой ученый.

Эксперимент в «упаковке»

Максим Губин, ведущий программист кафедры оптимизации систем управления Института кибернетики ТПУ, занимается первичной обработкой сырых данных, поступающих с БАК к участникам проекта ATLAS. А точнее, ведет поиск и устранение недочетов в компьютерной системе, обрабатывающей эти большие объемы информации в форму, с которой в дальнейшем смогут работать ученые. Задача политехника — обнаруживать закономерности, тормозящие обработку данных.

— К примеру, время выполнения задачи системой зачастую кратно минуте. Между тем ранее был проведен апгрейд, чтобы этот процесс измерялся в секундах. Не должно быть никаких тормозящих моментов. В то же время на выполнение задачи закономерно уходит около 50–70 секунд, а иногда — 110–130. По логике вещей такого быть не должно, — делится своими наблюдениями Максим.

Все недостатки, которые молодой ученый выявит, в дальнейшем он попытается разрешить, чтобы улучшить работу системы.

— Вторая моя задача — работа над созданием каталога данных и знаний ЦЕРНа (Data Knowledge Catalog). Мы попытаемся создать систему, которая свяжет все публикации ученых с наборами данных, получаемых с коллайдера. Так мы сможем изучить, благодаря каким данным БАК чаще делались полезные публикации. Если вдруг будет обнаружено, что они были получены с системными ошибками, а такое иногда бывает, и их следует отбросить, то единый каталог позволит быстро отследить публикацию с этими данными и отозвать ее, — говорит молодой ученый.

Единая база позволит анализировать и сами публикации ученых. Например, сейчас трудно заметить, что несколько групп ЦЕРНа работают над одними и теми же задачами. Коллаборации центра никак между собой не пересекаются, каждая работает над своим проектом. Единый каталог позволит определять пересечения интересов научных групп, тогда и сами ученые смогут отслеживать эти процессы. «Работы по созданию каталога только начинаются, — отмечает политехник, — сейчас ученые определяют, какой вид примет вся эта система в конечном результате».

— Полагаю, что полноценную работу над разработкой каталога я продолжу уже по окончании стажировки. По возвращении в Томск моя работа с ЦЕРНом продолжится дистанционно, — говорит Максим.

«Черный ящик» для физиков

Большие объемы информации после ее обработки необходимо сохранять, чтобы ученые могли в дальнейшем ею оперировать. Над этим работает коллега Максима — Татьяна Корчуганова, инженер-проектировщик кафедры электроники и автоматики физических установок Физико-технического института.

— Я занимаюсь мониторингом и улучшением системы «ПАНДА» (PanDA), являющейся своеобразным «черным ящиком» для ученых-физиков ЦЕРНа, — рассказывает Татьяна.

«PanDA» (PanDA — Production and Distributed Analysis — обработка данных и распределенный анализ) — централизованная система проекта ATLAS. Ученые вводят запросы в систему и получают готовые (обработанные) данные о результатах своих экспериментов на БАК.

— Система может анализировать информацию сразу для десятков групп физиков и обеспечивает для них единый доступ к глобальным ресурсам вычислительной сети ЦЕРНа Grid, расположенной по всему миру, — поясняет ученая. — Для отслеживания прогресса выполнения задачи, то есть того, что происходит в «черном ящике», ученые используют веб-монитор, чтобы «PanDA» выполняла свою работу быстро и без сбоев.

Новый веб-монитор ЦЕРНа был запущен летом 2014 года. Важной задачей ученых является его усовершенствование. И Татьяна как раз над этим работает.

Глобальный контроль

Куда же сохранять все эти данные? Ведь даже сотни компьютеров не хватит, чтобы все разместить. Однако ученые ЦЕРНа нашли выход из этой ситуации, разработав систему Grid. LCG (LHC Computing Grid) — глобальная вычислительная сеть ЦЕРНа, месторасположение которой — весь мир. В состав Grid входит 170 вычислительных центров из 36 стран. Их задача — получать, обрабатывать и сохранять информацию из ЦЕРНа.

Однако необходимо, чтобы кто-то определял, в какой из этих центров будет направлена информация о том или ином эксперименте. Ведь без строгого порядка в этих данных легко запутаться. Над тем, как улучшить систему распределения информации в системе Grid, получаемой участниками проекта ATLAS, работает Валерий Парубец, специалист кафедры прикладной математики Института кибернетики ТПУ.

— Моя задача состоит в том, чтобы доработать систему распределения данных. Проработать алгоритмы — куда и что следует отправлять. Большинство работников ЦЕРНа в итоге ничего и не заметят. Однако это избавит людей, которые занимаются хранением информации, от постоянных консультаций с экспертами о порядке приема этих данных, — отмечает Валерий. — С точки зрения «айтишника», это очень интересная задача — приходится ворочать колоссальными объемами информации, которая растекается по всему миру.

По возвращении в Томский политехнический университет участники проекта ATLAS продолжат удаленную работу с центром. Они будут работать в Лаборатории обработки и анализа больших объемов данных при центре RASA в Томске, которой руководит ученый ЦЕРНа, ведущий мировой специалист в области современных методов сбора, хранения, обработки и анализа данных для экспериментов и установок мегасайнс класса Алексей Климентов.

Виталина Михетко